谷歌嵌套学习新范式突破LLM持续学习瓶颈,解决灾难性遗忘

谷歌嵌套学习:突破LLM持续学习瓶颈的革命性范式

在人工智能领域,大语言模型的持续学习能力迎来了重大突破。谷歌最新推出的嵌套学习范式,为机器学习开辟了全新的发展路径。

这一创新方法标志着人工智能向「类脑进化」方向迈出了关键一步,有望彻底改变现有模型的学习方式。

嵌套学习发布后立即在技术社区引发热烈讨论。许多专家认为,这是实现真正自适应、自我改进智能系统的重要里程碑。

持续学习的核心挑战

尽管过去十年机器学习取得了显著进展,但大语言模型仍面临根本性难题——持续学习困境。模型能否在吸收新知识的同时保持原有技能不退化,成为制约AI发展的关键瓶颈。

人脑通过神经可塑性不断适应新经验,而当前LLM的知识局限在预训练阶段和有限上下文窗口内。简单更新参数往往导致灾难性遗忘——新技能覆盖旧能力。

嵌套学习的核心理念

谷歌在NeurIPS 2025发表的论文《Nested Learning: The Illusion of Deep Learning Architectures》提出了突破性解决方案。该研究认为,模型架构与优化算法本质上是同一事物的不同表现,只是处于不同的优化层级。

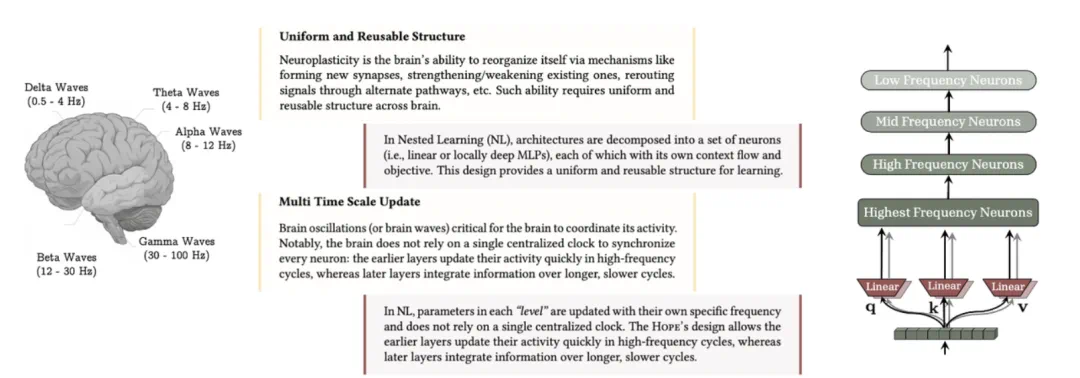

嵌套学习将机器学习模型视为多层次优化问题的集合,每个子问题拥有独立的信息流和更新频率。这种统一视角为解决灾难性遗忘提供了全新思路。

- 论文标题:Nested Learning: The Illusion of Deep Learning Architectures

- 论文地址:https://abehrouz.github.io/files/NL.pdf

嵌套学习的技术实现

嵌套学习揭示了一个关键洞察:复杂模型实际上是相互嵌套的优化问题网络。传统方法压缩了内部信息流,而嵌套学习通过定义更新频率,构建了层次化的学习组件。

以联想记忆为例,训练过程中的反向传播可建模为记忆机制,将数据点映射到其意外程度。同样,Transformer注意力机制也能形式化为联想记忆模块。

人脑的多时间尺度更新是持续学习的关键。嵌套学习使模型组件能以不同频率更新,常见架构实质上是具有差异化更新速率的线性层。

实际应用与创新

深度优化器

嵌套学习将优化器视为联想记忆模块,通过改进相似度度量标准,开发出对噪声数据更具鲁棒性的新型优化算法。

连续体记忆系统

传统Transformer的记忆功能被扩展为连续体记忆系统,其中记忆模块以特定频率更新,为持续学习构建了更高效的记忆架构。

Hope架构:自我修改的突破

基于嵌套学习原理,谷歌设计了Hope自我修改架构。与仅支持两阶更新的Titans架构不同,Hope能够执行无限层次的上下文学习,通过连续体记忆系统扩展上下文窗口。

Hope通过自我引用过程优化记忆,形成了无限循环的学习层次结构,展现出卓越的持续学习能力。

实验成果与性能表现

谷歌在多个基准测试中验证了嵌套学习框架的有效性:

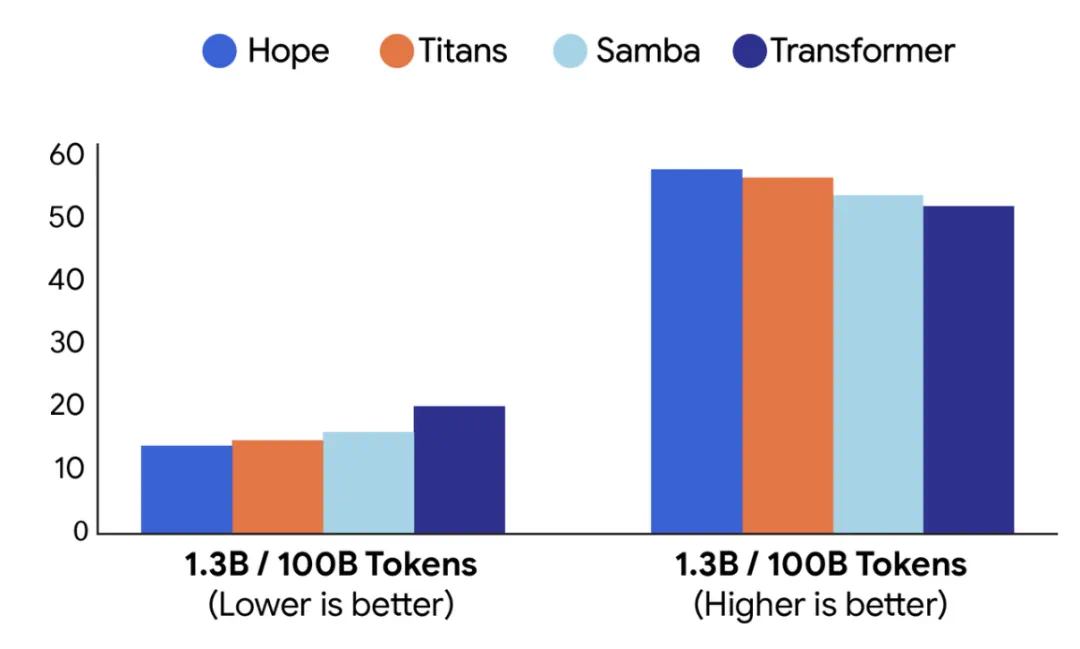

Hope在语言建模和常识推理任务中表现出色,取得了更低的困惑度和更高的准确率。

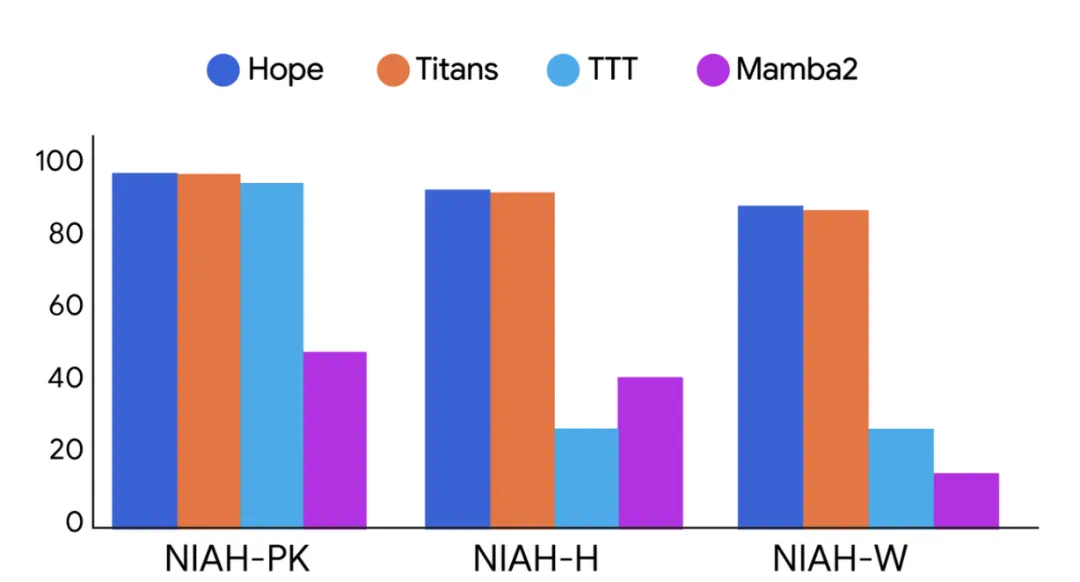

在长上下文大海捞针任务中,Hope展现出卓越的记忆管理能力,证明连续体记忆系统在处理扩展序列方面具有显著优势。

未来展望

嵌套学习代表了深度学习理解的新高度,通过统一架构与优化的层次化视角,开启了全新的设计维度。Hope模型的成功证明,这种系统整合方法能够带来更强的表达能力、更高效率和持续学习能力。

这项技术为弥合当前LLM局限与人脑学习能力之间的差距奠定了坚实基础,为构建下一代自我改进人工智能开辟了充满希望的前景。

参考链接: https://research.google/blog/introducing-nested-learning-a-new-ml-paradigm-for-continual-learning/ https://x.com/behrouz_ali/status/1986875258935066946 https://x.com/JeffDean/status/1986938111839129858

想获取更多AI最新资讯与智能工具推荐, 欢迎访问 👉 AI Tools Nav ——优质的 AI导航平台 与 AI学习社区

本文来源:机器之心

原文链接:https://www.jiqizhixin.com/articles/c28819bc-2cb3-41c7-b8e3-d8719b24cbbb