Video-RAG:轻量高效的长视频理解与多模态对齐框架

Video-RAG:突破长视频理解瓶颈的创新框架

在人工智能快速发展的今天,视觉语言模型(LVLMs)虽然在图像识别和短视频分析领域取得了令人瞩目的成就,但当面对长时间、复杂叙事的视频内容时,这些模型却显得力不从心。上下文长度受限、跨模态信息对齐困难以及高昂的计算成本,成为制约其实际应用的主要障碍。

针对这一行业痛点,厦门大学、罗切斯特大学与南京大学的研究团队联合研发了Video-RAG——一个轻量级、高效率且无需微调的视频理解框架。这项突破性研究已被机器学习领域的顶级会议NeurIPS 2025接收,为长视频理解任务开辟了全新的技术路径。

项目主页:https://video-rag.github.io/

论文链接:https://arxiv.org/abs/2411.13093

开源代码:https://github.com/Leon1207/Video-RAG-master

现有技术面临的挑战

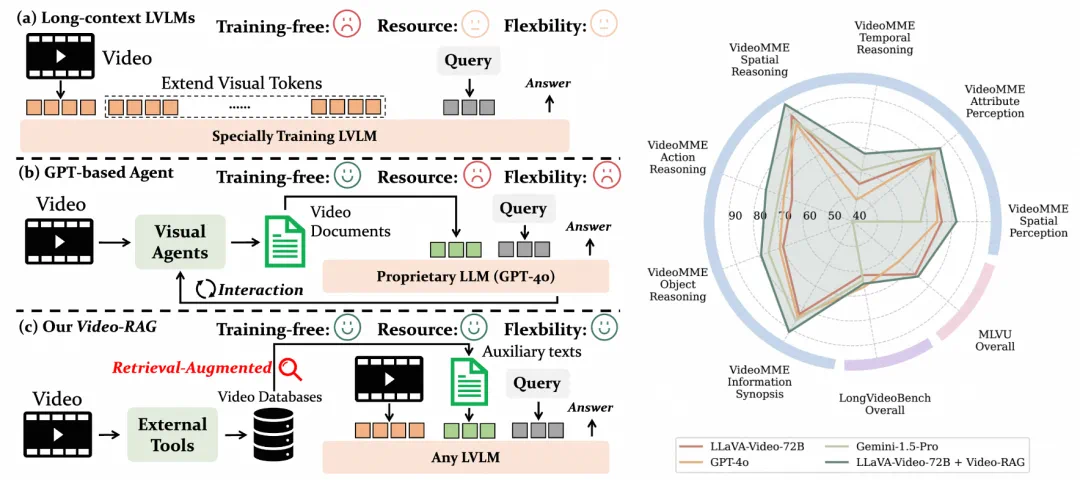

当前主流的长视频理解方案主要存在两大技术路线:

扩展上下文方法:以LongVA为代表,这种方法需要依赖大规模的长视频-文本配对数据进行模型微调,不仅训练成本高昂,而且高质量的训练数据极为稀缺。

智能体驱动方法:如VideoAgent,通过任务分解和外部代理决策来增强推理能力,但频繁调用GPT-4o等商业API导致运营成本居高不下。

更为关键的是,这两种方法在处理长时间跨度的视觉-语义对齐任务时表现有限,往往需要在效率和精度之间做出妥协,难以同时满足实用性和可扩展性的要求。

创新技术:检索增强的跨模态桥梁

Video-RAG开创性地提出了基于多模态辅助文本的检索增强生成(RAG)技术路线,既不依赖模型微调,也无需昂贵的商业大模型支持。其核心理念是从视频内容中提取与视觉信息高度对齐的文本线索,通过按需检索的方式将这些线索注入现有的LVLM输入流程,实现精准的语义引导和内容增强。

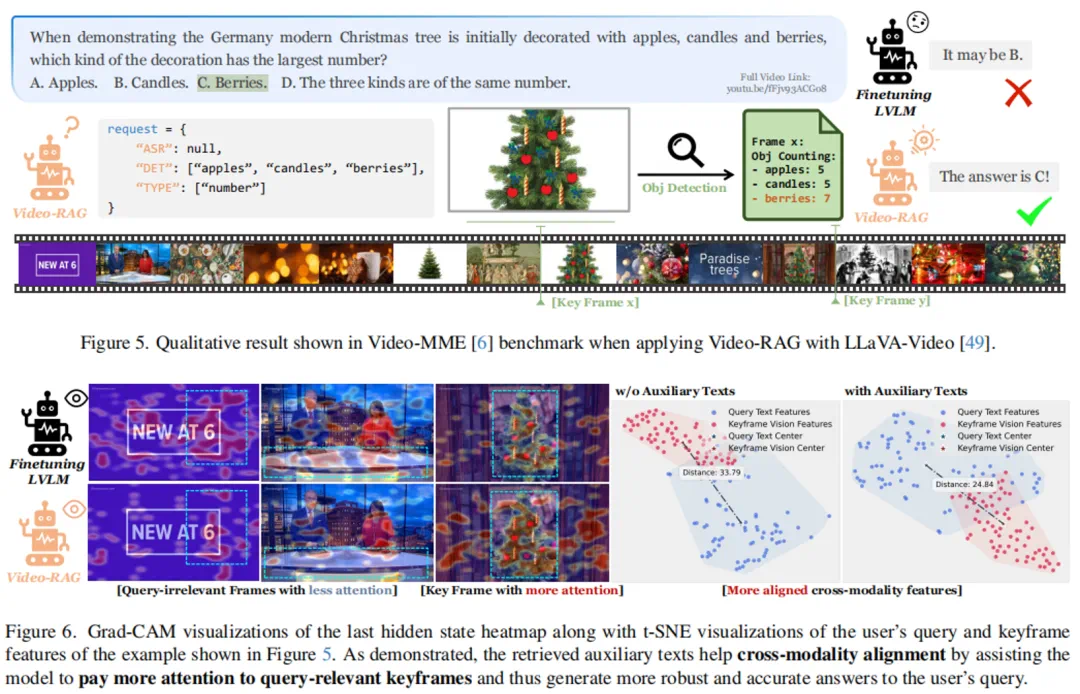

该框架的具体工作流程包含三个关键步骤:

1. 智能查询解耦

系统能够自动将用户提出的复杂问题拆解为多个结构化的检索请求(采用JSON格式),指导系统从不同的模态数据库中查找相关信息。在这一阶段,LVLM仅处理文本信息,不直接接触视频帧数据,从而显著降低了初期的计算负担。

2. 多模态数据库构建与检索

利用开源工具构建三大语义对齐数据库:

OCR文本库:采用EasyOCR技术提取视频帧中的文字信息,结合Contriever编码和FAISS向量索引,实现快速精准的文本检索。

语音转录库:通过Whisper模型提取视频中的音频内容,并将其转换为文本形式进行存储和索引。

对象语义库:运用APE模型检测关键帧中的物体及其空间关系,经过场景图预处理生成结构化的描述文本。

这些生成的文本不仅与视频画面保持高度同步,还具备明确的语义标签,有效解决了传统采样帧缺乏上下文关联的技术难题。

3. 智能信息融合与响应生成

将检索到的相关文本片段、原始用户问题以及少量关键视频帧共同输入现有的LVLM(如LLaMA-VID、Qwen-VL等),由模型完成最终的推理和输出。整个处理过程实现了真正的即插即用,无需进行任何模型微调,大幅降低了技术部署门槛和计算资源消耗。

通过检索机制的引入,LVLM能够将更多的计算注意力集中在对应的关键视觉信息上,有效缩小了不同模态之间的语义鸿沟:

技术优势:轻量化与高性能的完美结合

即插即用的兼容性:框架能够兼容任意开源LVLM,无需修改模型架构或进行重新训练。

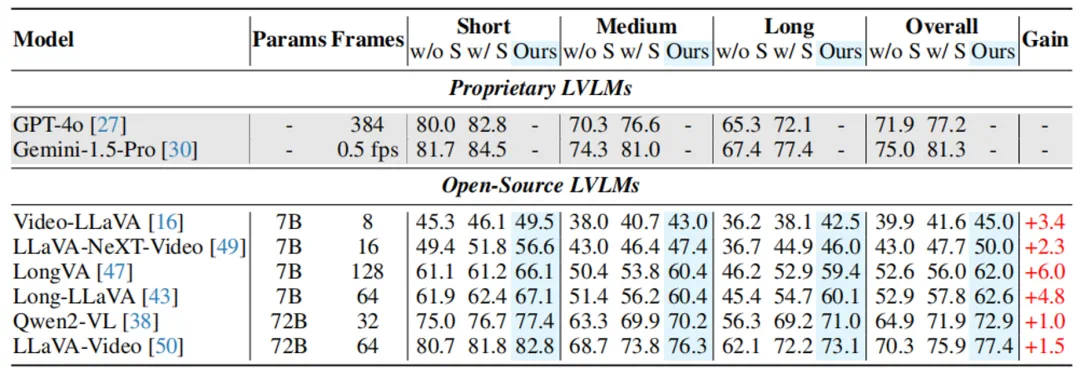

卓越的资源效率:在Video-MME基准测试中,平均每个问题仅增加约2000个token的处理量,远低于主流智能体方法的通信和计算开销。

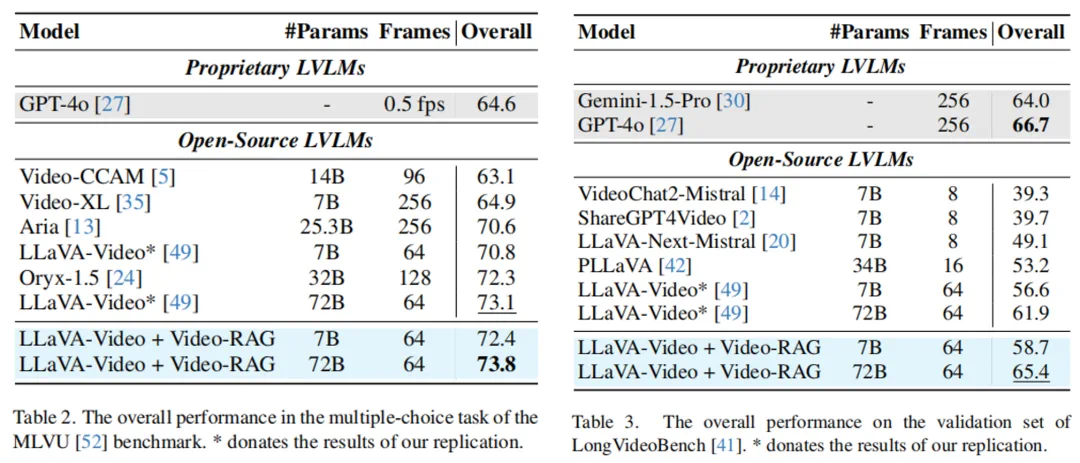

领先的性能表现:当与72B参数规模的开源LVLM结合使用时,Video-RAG在多个长视频理解基准测试中超越了GPT-4o和Gemini 1.5等商业闭源模型,展现出卓越的竞争力。

研究成果与行业意义

Video-RAG的成功验证了一个重要的技术方向:通过引入高质量、视觉对齐的辅助文本作为外部知识源,可以在不改变现有模型架构的前提下,有效突破上下文窗口的技术瓶颈,显著提升跨模态理解能力。该框架不仅成功解决了长视频理解中的"幻觉"和"注意力分散"问题,更为行业构建了一套低成本、高可扩展性的技术范式,在教育培训、安防监控、医疗影像分析等多个实际应用场景中展现出广阔的应用前景。

想获取更多AI最新资讯与智能工具推荐, 欢迎访问 👉 AI Tools Nav ——优质的 AI导航平台 与 AI学习社区

本文来源:机器之心

原文链接:https://www.jiqizhixin.com/articles/839a2ddf-5a7a-4262-9c51-913c2d7a323c